Cuando hablamos de SEO y optimización de sitios web, uno de los elementos más importantes que debes considerar es el archivo robots.txt. Pero, ¿cómo generar y editar el archivo robots.txt en WordPress? Este archivo es clave para controlar cómo los motores de búsqueda rastrean e indexan tu contenido. Como consultor SEO en Madrid, te explicaré qué es el archivo robots.txt, por qué es esencial para tu estrategia de SEO y cómo puedes editarlo fácilmente en tu sitio de WordPress.

¿Qué es el archivo robots.txt?

El archivo robots.txt es un archivo de texto que sirve para guiar a los motores de búsqueda sobre cómo deben rastrear e indexar las páginas de tu sitio web. En esencia, es una herramienta de comunicación con los bots de los motores de búsqueda, donde puedes indicarles qué partes de tu sitio deseas que exploren y cuáles prefieres que ignoren.

Aunque no es obligatorio crear un archivo robots.txt, es altamente recomendable, ya que puede influir positivamente en el posicionamiento de tu web. Las páginas más pequeñas, que cuentan con pocas URL y contenido, pueden prescindir de este archivo o limitarse a incluir solo algunas instrucciones básicas.

Por otro lado, en el caso de sitios web más grandes, contar con un archivo robots.txt es esencial. Este archivo facilita el rastreo por parte de los bots, evitando que la página se vea saturada de solicitudes innecesarias. Sin un archivo robots.txt, muchas arañas tendrán acceso completo a tu sitio, lo que podría impactar negativamente en su rendimiento y velocidad, haciendo que la experiencia del usuario sea menos satisfactoria.

Es importante señalar que, en muchas ocasiones, los bots de Google no siempre siguen al pie de la letra las instrucciones que les proporcionas. De hecho, Google mismo menciona que el archivo robots.txt no impide la indexación de una página. Las directrices que incluyas en este archivo son más bien sugerencias para los bots, no reglas estrictas que deban seguir al 100%.

¿Por qué es importante el archivo Robots.txt?

El archivo robots.txt es crucial para el SEO porque permite gestionar la visibilidad de tu contenido en los motores de búsqueda. Al restringir el acceso a ciertas secciones de tu sitio, puedes evitar que se indexe contenido que no deseas que aparezca en los resultados de búsqueda.

Es común que tu web contenga partes innecesarias en las que no quieres que los bots de búsqueda pierdan tiempo rastreándolas. Para agilizar este proceso y facilitar el trabajo de las arañas de los buscadores, se utiliza el archivo robots.txt.

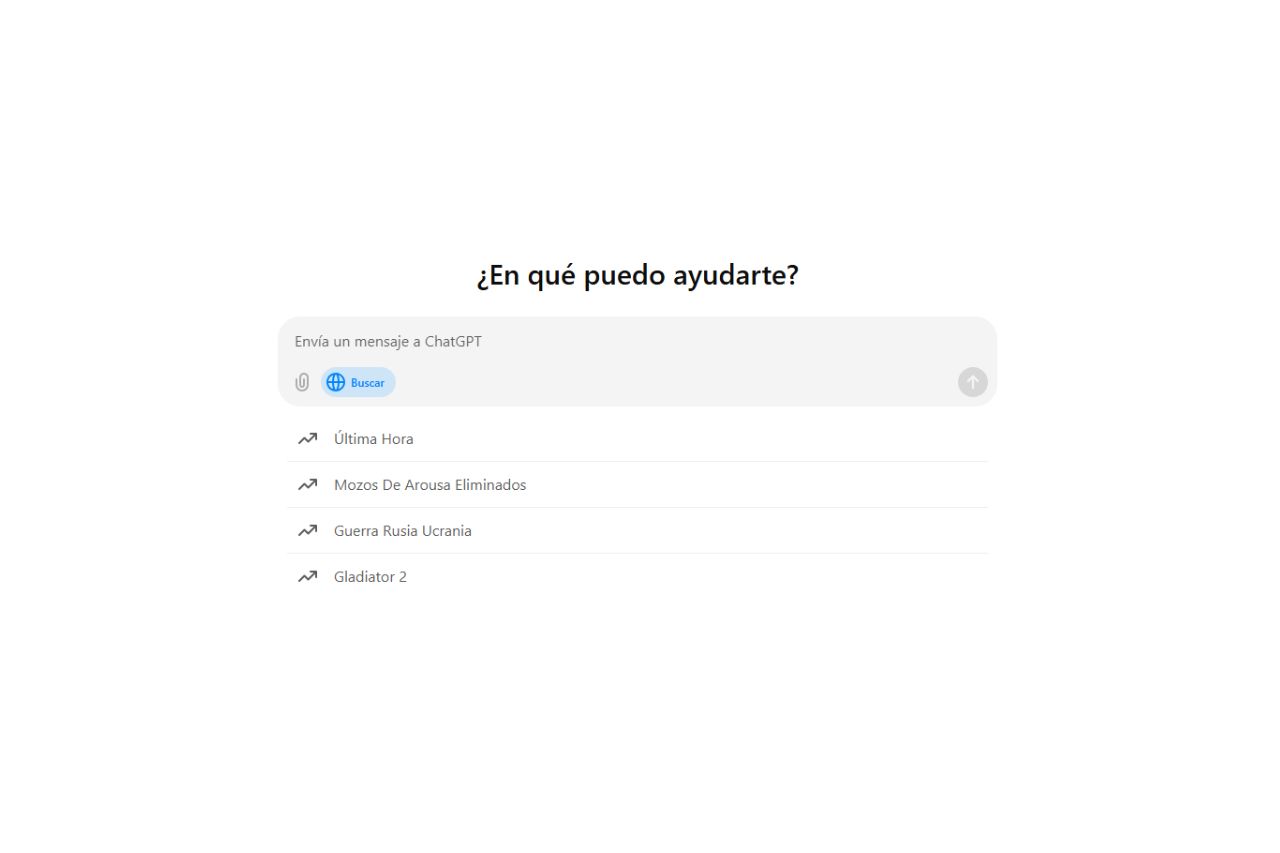

¿Cómo funciona el archivo robots.txt?

El archivo funciona a través de directivas, que son instrucciones específicas que le indicas a los robots. Por ejemplo, puedes permitir que un motor de búsqueda acceda a toda tu página, o, por el contrario, bloquear el acceso a secciones específicas.

Directivas más comunes en Robots.txt

User-agent

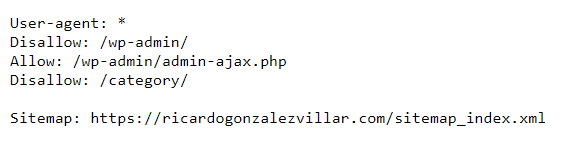

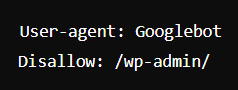

Cada motor de búsqueda utiliza diferentes rastreadores, o «bots», para acceder y analizar el contenido de los sitios web. Por ejemplo, si deseas impedir que el rastreador de Google, conocido como Googlebot, acceda a ciertas partes de tu sitio (como el área de administración de WordPress), podrías configurar tu archivo robots.txt de la siguiente manera:

Este bloque de comandos le dice específicamente al bot de Google que no debe rastrear la carpeta /wp-admin/, protegiendo así esa área de tu sitio del rastreo de Google.

Es importante tener en cuenta que los motores de búsqueda, como Google, suelen emplear múltiples rastreadores especializados para indexar diferentes tipos de contenido. Por ejemplo, Google tiene rastreadores separados para su índice estándar, imágenes, vídeos, noticias, etc. Los rastreadores más comunes incluyen:

- Googlebot: Utilizado para indexar contenido web normal.

- Googlebot-Image: Utilizado para indexar imágenes.

- Googlebot-Video: Usado para indexar contenido en vídeo.

- Googlebot-News: Específico para indexar contenido de noticias.

Si necesitas más información sobre los diferentes rastreadores y sus respectivos user-agents, puedes consultar una lista completa y actualizada proporcionada por los motores de búsqueda, como Google o Bing, donde se detalla cada uno de sus rastreadores especializados y las funciones que desempeñan.

Disallow

Después del comando User-agent, la segunda línea de cualquier bloque de comandos en el archivo robots.txt es el comando Disallow. Este comando indica a los motores de búsqueda qué partes de tu sitio no deben ser rastreadas. A través de varias directivas Disallow, puedes especificar múltiples secciones o URL que deseas proteger del acceso de los rastreadores.

Puedes tener tantas líneas Disallow como necesites para definir las rutas que no quieres que los bots rastreen. Si en algún bloque de comandos el valor de Disallow está vacío, esto significa que no estás bloqueando ninguna URL, por lo que los rastreadores tendrán acceso a todas las secciones de tu web.

Los comandos como Allow y Disallow no distinguen entre mayúsculas y minúsculas. Es decir, puedes escribirlos como prefieras: Allow o allow, Disallow o disallow, y el comportamiento será el mismo. Sin embargo, cuando se trata de los valores dentro de estos comandos (como las rutas de URL), es importante saber que sí se distingue entre mayúsculas y minúsculas.

Por ejemplo:

/foto/ no es lo mismo que /Foto/.

Allow

El comando Allow en el archivo robots.txt es utilizado para permitir el acceso a ciertas páginas o subdirectorios específicos, incluso cuando el directorio principal ha sido bloqueado por una directiva Disallow. Este comando es útil cuando deseas bloquear el acceso general a un directorio, pero necesitas que algunas páginas o subdirectorios dentro de ese directorio sean accesibles para los motores de búsqueda.

Sitemap

El comando Sitemap en el archivo robots.txt es una directiva que indica a los motores de búsqueda, como Google, Bing y Yandex, la ubicación exacta de tu sitemap XML. El sitemap XML es un archivo que contiene una lista estructurada de todas las páginas importantes de tu sitio web, las cuales deseas que los motores de búsqueda rastreen e indexen.

¿Cómo crear un archivo robots.txt en WordPress?

Crear un archivo robots.txt en WordPress es un proceso bastante sencillo. Sin embargo, antes de proceder, es importante verificar si tu sitio ya cuenta con uno.

Para comprobar si un sitio web tiene el archivo robots.txt, simplemente debes añadir «/robots.txt» al final de tu dominio en la barra de direcciones del navegador. Por ejemplo: https://dominio.com/robots.txt.

Editar archivo robots.txt en WordPress

Usando un plugin

Una de las formas más fáciles de crear y editar el archivo robots.txt en WordPress es mediante el uso de plugins. Dos de los más populares son:

- Rank Math

- Yoast SEO

Manualmente

Si prefieres tener un control total sobre el archivo, puedes crearlo y editarlo manualmente a través de FTP.

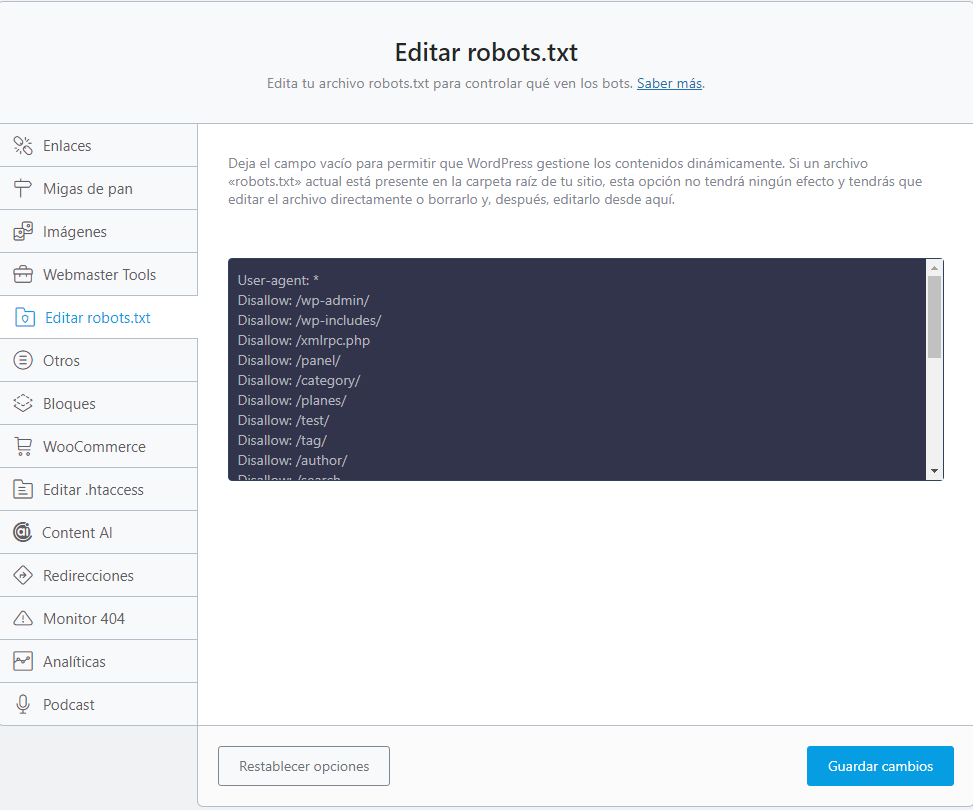

Editar archivo robots.txt con Rank Math

Para editar el archivo robots.txt en WordPress utilizando el plugin Rank Math, sigue estos pasos:

- Accede al panel de administración de WordPress.

- Navega a Rank Math en el menú lateral.

- Dirígete a la pestaña de Ajustes Generales.

- Busca la opción Editar robots.txt.

- Realiza los cambios necesarios en el campo correspondiente. Aquí puedes agregar, modificar o eliminar directrices según tus necesidades.

- Guarda los cambios para asegurarte de que tus nuevas configuraciones se apliquen correctamente.

Editar archivo robots.txt con Yoast SEO

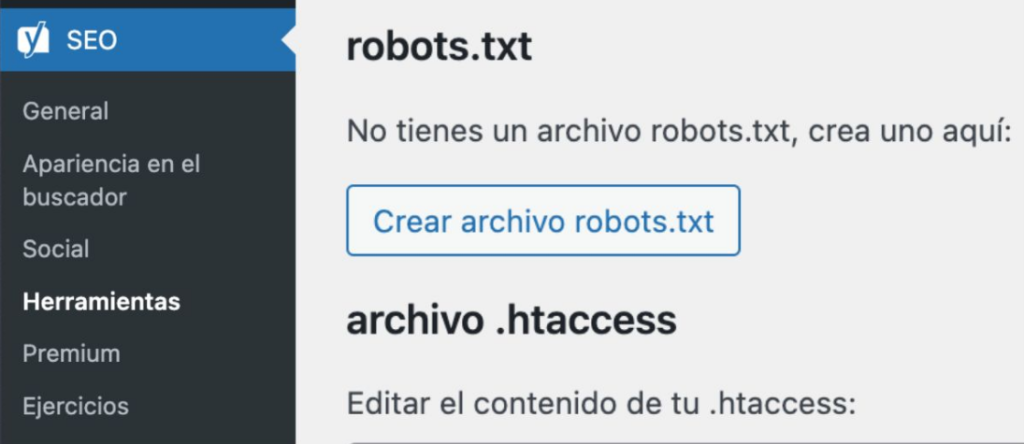

Para editar el archivo robots.txt en WordPress utilizando el plugin Yoast SEO, sigue estos pasos:

- Accede al panel de administración de WordPress.

- Navega a Yoast SEO en el menú lateral.

- Dirígete a Herramientas y selecciona Editor de archivos.

- Si aún no tienes un archivo robots.txt, haz clic en el botón Crear archivo robots.txt.

Al presionar este botón, se generará el archivo, permitiéndote editarlo fácilmente. Aquí podrás establecer tus directrices específicas y añadir la URL de tu Sitemap, lo que ayudará a los motores de búsqueda a indexar tu contenido de manera más eficiente.

Editar archivo robots.txt manualmente

Si prefieres tener un control total sobre tu archivo robots.txt, puedes editarlo manualmente. A continuación, te mostramos cómo hacerlo:

- Accede a tu servidor FTP: Utiliza un cliente FTP, como FileZilla, para conectarte a tu servidor.

- Navega a la raíz de tu instalación de WordPress: Busca la carpeta donde se encuentra tu WordPress, normalmente en public_html o en una carpeta específica para tu dominio.

- Crea o edita el archivo robots.txt:

- Si no existe, puedes crear un nuevo archivo de texto y nombrarlo robots.txt.

- Si ya está presente, descárgalo, edítalo con un editor de texto y vuelve a subirlo.

4. Agrega tus directrices: En el archivo, puedes especificar qué partes de tu sitio deseas que los motores de búsqueda rastreen o ignoren.

5. Guarda los cambios: Asegúrate de que el archivo esté guardado en formato de texto y vuelve a cargarlo a tu servidor.

¿Cómo indicar a Google que he creado el robots.txt?

Informar a Google sobre la creación de tu archivo robots.txt es un proceso sencillo y efectivo. Sigue estos pasos:

- Accede a Google Search Console: Inicia sesión en tu cuenta y dirígete al panel de control.

- Busca la sección de ayuda: En la barra de búsqueda, escribe «robots.txt».

- Selecciona la opción «Probar tu archivo robots.txt»: Este será el primer resultado que aparecerá.

- Elige tu propiedad: Selecciona el dominio correspondiente a tu sitio web.

- Copia el contenido de tu archivo robots.txt: Si tienes el archivo guardado en un bloc de notas o en un plugin SEO, simplemente copia todo su contenido.

- Haz clic en «Enviar»: Después de pegar el contenido, busca la opción “Solicita a Google la actualización” y selecciónala.

Para facilitar el proceso, puedes acceder al validador de robots.txt en Search Console, para verificar que no haya errores en el archivo antes de enviarlo para asegurarte de que Google lo interprete correctamente.